Технологические компании, включая OpenAI и Google, заявили законодателям и судам, что им должно быть позволено получать как можно больше данных из сети, чтобы создавать передовые системы искусственного интеллекта.

Новое исследование показывает, что проверка информации, вложенной в алгоритмы машинного обучения, может облегчить решение проблем безопасности искусственного интеллекта.

Полученные результаты могут послужить оружием для регулирующих органов, которые хотят, чтобы компании, занимающиеся разработкой искусственного интеллекта, были более прозрачными и ответственными за выбор, который руководители делают в отношении огромных массивов данных, используемых в генеративном искусственном интеллекте.

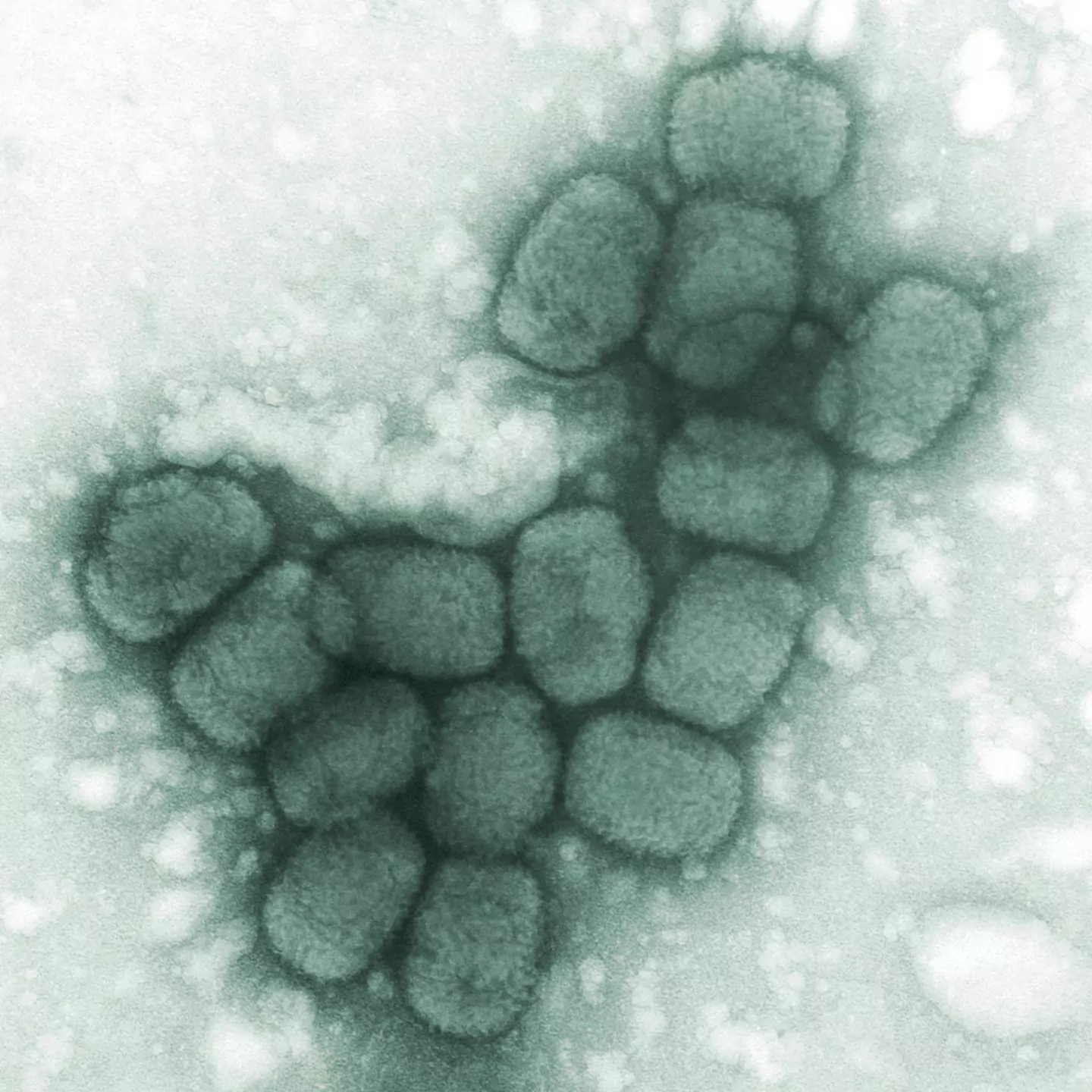

Исследование было проведено совместно Институтом безопасности ИИ при правительстве Великобритании и некоммерческой лабораторией Eleuther AI. Они обнаружили, что фильтрация данных, используемых для обучения системы ИИ, для удаления ключевых концепций может снизить её способность помогать пользователю в работе с биологическими опасностями, такими как новое биологическое оружие. И это решение не привело к общему снижению общих возможностей системы.

Для проверки своей методики, получившей название «глубокое незнание», исследователи обучили несколько версий программного обеспечения ИИ с открытым исходным кодом для работы с текстом под названием Pythia-6.9B, разработанного компанией Eleuther. Некоторые из них были созданы на основе копий стандартного набора данных онлайн-текстов, которые были отфильтрованы для удаления потенциально опасной информации, такой как исследования по расширенным пандемическим патогенам, биотерроризму и вирусологии двойного назначения.

В ходе испытаний версии программного обеспечения ИИ, созданные на основе отфильтрованных данных, показали более высокие результаты в тестах, предназначенных для проверки возможностей ИИ в биорисках.

Дальнейшие эксперименты показали, что это не привело к снижению общей производительности системы ИИ или производительности при решении вопросов по биологии в средней школе, хотя при решении вопросов по биологии на уровне колледжа наблюдалось небольшое снижение точности.

Исследователи утверждают, что их методы не слишком обременительны и что их фильтрация потребовала менее чем 1-процентного увеличения вычислительной мощности, используемой для создания модели ИИ.

Открытые модели ИИ могут использоваться и модифицироваться кем угодно, поэтому их сложно контролировать. Но исследователи утверждают, что их метод фильтрации данных значительно усложняет настройку готовой модели ИИ для специализации на биооружии.

Полученные результаты говорят о том, что политикам, возможно, придется поставить под сомнение одну из давно устоявшихся концепций индустрии ИИ.

Крупнейшие компании, занимающиеся разработкой ИИ, постоянно утверждали, что, поскольку недавние прорывы в области ИИ, приведшие к появлению таких продуктов, как ChatGPT, стали результатом обучения алгоритмов на большем количестве данных, наборы данных слишком колоссальны, чтобы полностью документировать или фильтровать их, а удаление данных сделает модели менее полезными. Поэтому усилия по обеспечению безопасности должны быть направлены в основном на корректировку поведения систем ИИ после их создания.

«Компании продают свои данные как непостижимо большие и недоступные для документирования», — говорит исполнительный директор Eleuther, Стелла Бидерман, которая возглавила проект. «Подвергать сомнению проектные решения, которые принимаются при создании моделей, крайне не рекомендуется».

По словам Бидерман, демонстрация эффектов фильтрации огромных массивов данных может побудить разработчиков ИИ использовать аналогичный подход для борьбы с другими потенциальными вредными последствиями ИИ, такими как несанкционированные интимные снимки. Она предупредила, что подход, использованный в исследовании, вероятно, лучше всего работает в таких областях, как ядерное оружие, где можно удалить специализированные данные, не затрагивая общую информацию.

Некоторые компании, занимающиеся разработкой ИИ, заявили, что уже фильтруют данные для обучения, чтобы повысить безопасность.

В опубликованном на прошлой неделе отчете OpenAI о безопасности последних релизов ИИ, создатель ChatGPT заявил, что отфильтровывает вредный контент из обучающих данных.

Для модели GPT-OSS с открытым исходным кодом это включало удаление контента, связанного с «опасными знаниями в области биобезопасности». Для своего флагманского релиза GPT-5 компания заявила, что ее усилия включали использование «расширенной фильтрации данных» для уменьшения количества личной информации в обучающих данных.

Но компания не предоставила подробностей о том, что именно включает в себя эта фильтрация и какие данные она удаляет, что затрудняет проверку и развитие работы сторонних разработчиков. Отвечая на вопросы, OpenAI сослалась на два отчета о тестировании безопасности.

По словам Бидерман, компания Eleuther уже начала изучать возможности демонстрации методов обеспечения безопасности, более прозрачных, чем существующие, которые, по ее словам, «не так уж сложно устранить».